Langdock Einsteiger Workshop

Enterprise AI Betriebssystem im Team einsetzen

Folie 01

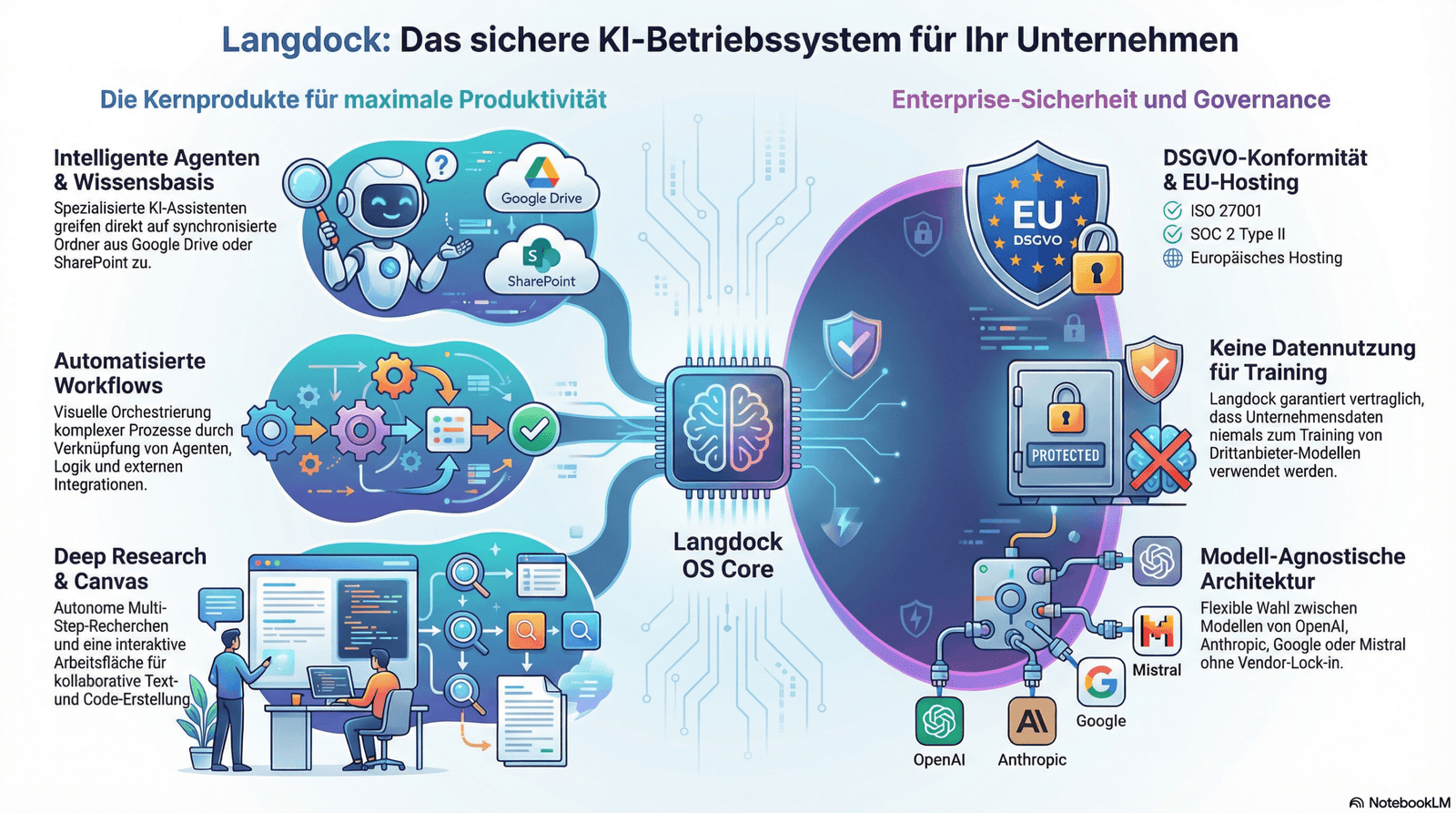

Langdock als Enterprise AI Betriebssystem

Diese Präsentation führt dich strukturiert von den Grundlagen bis zur teamfähigen Umsetzung. Fokus: sichere Nutzung, wiederholbare Qualität und schnelle Wertschöpfung im Arbeitsalltag.

10

Folien

20

Quizfragen

90

Minuten Setup

Folie 02

Workshop Roadmap

00-10 min

Warum Langdock

Produktvision, zentrale Bausteine, Nutzen für Unternehmen.

10-30 min

Oberfläche & erste Prompts

Navigation, Projektstruktur, Prompt-Grundlagen.

30-60 min

Feature Deep Dive

Document Search, Data Analysis, Canvas, Deep Research, Agents.

60-80 min

Governance & Rollout

Datenschutz, Rollen, Qualitätskontrollen, Team-Einführung.

80-90 min

Quiz & nächste Schritte

Wissenscheck mit 20 Fragen und Handlungsplan.

Folie 03

Plattformverständnis: Die fünf Kernbereiche

Chat

Direkte Interaktion für Texte, Ideen, Entscheidungen und schnelle Entwürfe.

Agenten

Wiederkehrende Aufgaben standardisieren und mit klaren Regeln ausführen.

API

KI-Funktionen in interne Systeme, Portale und Automationen integrieren.

Integrationen

Bestehende Tools anbinden, statt Kontext manuell zu kopieren.

Workflows

Mehrstufige Prozesse per Trigger, Regeln und Outputs automatisieren.

Was das für Teams bedeutet

Langdock ist nicht nur ein Chatfenster. Es ist ein Betriebsmodell für AI-Arbeit: standardisiert, prüfbar und skalierbar über Abteilungen hinweg.

Folie 04

Onboarding: So startest du richtig

Ziel dieser Folie: Nach 15 Minuten kann jedes Teammitglied selbstständig ein sinnvolles Projekt aufsetzen, den ersten brauchbaren Prompt erstellen und Ergebnisse qualitätsgesichert weiterverwenden.

1. Orientierung

- Login über langdock.com: Im Workspace anmelden, Teamkontext wählen und prüfen, ob du im richtigen Arbeitsbereich bist.

- Sidebar und Dashboard: Verstehen, wo aktive Chats, Projekte, Dokumente und zuletzt genutzte Inhalte sichtbar sind.

- Cmd/Ctrl + K: Schneller Wechsel zwischen Bereichen, Projekten und Funktionen ohne Umwege.

2. Projektstruktur

- Ein Use Case pro Projekt: Keine Mischprojekte; z. B. „Exposé-Optimierung“ getrennt von „Lead-Analyse“.

- Dateien + Kontext + Ziel: Alle relevanten Inputs im selben Projekt bündeln, damit Antworten konsistent bleiben.

- Rollen klar trennen: Owner steuert Standards, Editor arbeitet operativ, Viewer prüft Ergebnisse.

3. Modellwahl

Konkrete Auswahl (Stand: 6. Februar 2026, laut Langdock Modellguide):

-

Alltägliche Standardaufgaben:

GPT-5.1als Allrounder für Chat, Schreiben, Analyse. -

Text + Programmierung:

Claude Sonnet 4.5(bzw.Claude Sonnet 4.5 Reasoningfür schwerere Fälle). -

Komplexe Analyse/Reasoning:

GPT-5.1 Thinkingfür mehrstufige, präzise Aufgaben. -

Schnell + kosteneffizient:

GPT-5 minifür häufige Routineanfragen und schnelle Iterationen. -

Sehr lange Kontexte/multimodal:

Gemini 2.5 Pro(Tiefe) oderGemini 2.5 Flash(Tempo). -

Wichtig: Für neue Nutzer ist laut Doku

GPT-4.1oft als persönlicher Standard vorbelegt.

Team-Standard vorschlagen: Default = GPT-5.1,

Analyse = GPT-5.1 Thinking, Schreiben/Coding = Claude Sonnet 4.5,

Schnellmodus = GPT-5 mini.

4. Qualität sichern

- Review vor externer Nutzung: Fachliche Richtigkeit, Tonalität und Compliance kurz gegenchecken.

- Prompts versionieren: Gute Prompts als Vorlage speichern und mit Datum/Zweck nachvollziehbar halten.

- Fehler dokumentieren: Schwache Antworten als Lernfälle festhalten und Standards verbessern.

Erste 15 Minuten: konkreter Ablauf

- Minute 0-3: Projekt mit klarem Zweck anlegen (z. B. Exposé-Optimierung).

- Minute 3-6: 2-3 relevante Dateien hochladen und mit sprechenden Namen versehen.

- Minute 6-9: Ersten Prompt mit Ziel, Zielgruppe und gewünschtem Format starten.

- Minute 9-12: Follow-up einsetzen, um Präzision und Stil zu verbessern.

- Minute 12-15: Bestes Ergebnis speichern und als Team-Referenz markieren.

Praxisbeispiel: Immobilien-Team

Ziel: Eine Objektbeschreibung in drei Varianten erstellen (Premium, neutral, kurz für Social Media).

- Input: Lage, Ausstattung, Besonderheiten, Zielgruppe, gewünschte Tonalität.

- Output: Drei Versionen mit einheitlichem Aufbau (Headline, Kernnutzen, Details, Call-to-Action).

- Review: Fachliche Korrektheit, rechtlich saubere Sprache und konsistenter Markenstil.

Typische Onboarding-Fehler und schnelle Lösung

- Fehler: Prompt zu allgemein. Lösung: Ziel, Kontext und Format ergänzen.

- Fehler: Zu viel in einem Chat gemischt. Lösung: Pro Use Case ein Projekt.

- Fehler: Ergebnisse ungeprüft übernommen. Lösung: Pflicht-Review vor Veröffentlichung.

Folie 05

Prompting Framework für verlässliche Ergebnisse

Prompt-Formel

- Rolle: Wer soll die KI sein?

- Ziel: Was soll konkret erzeugt werden?

- Kontext: Für wen und in welcher Situation?

- Format: Welche Struktur wird erwartet?

- Prüfkriterien: Wann ist das Ergebnis gut?

Vorlage

Rolle: Du bist [Rolle].

Ziel: Erstelle [Output].

Kontext: [Zielgruppe/Anlass].

Format: [Tabelle/Liste/Text].

Qualitätskriterien: [präzise, kurz, faktenbasiert].

Typische Fehler vermeiden

- Unklare Aufgabe ohne Zielbild

- Zu wenig Kontext für den gewünschten Ton

- Keine Iteration per Follow-up

- Ungeprüfte Übernahme von Aussagen

Folie 06

Feature Deep Dive: Praxis statt Theorie

Document Search

Dokumente hochladen und inhaltlich mit Quellenbezug durchsuchen.

Übung: „Extrahiere Risiken und Chancen mit Priorität.“

Data Analysis

CSV/XLSX/TSV analysieren, Trends visualisieren, Entscheidungen vorbereiten.

Übung: „Welche Segmente entwickeln sich positiv?“

Canvas for Writing

Längere Texte iterativ planen, kürzen und auf Zielgruppe zuschneiden.

Übung: „Baue eine 5-teilige Landingpage-Struktur.“

Deep Research

Mehrstufige Recherche mit nachvollziehbarer Struktur und Ergebnisbericht.

Übung: „Marktüberblick mit Risiken und Maßnahmen.“

Agenten

Wiederkehrende Aufgaben als feste Prozesse inkl. Rollen und Outputformate.

Übung: „Lead-Qualifizierungs-Agent mit Score-Logik.“

Prompt Library

Teamweit wiederverwendbare Prompts für konsistente Ergebnisse.

Übung: „3 Standardprompts für Vertrieb und Support.“

Folie 07

Governance, Sicherheit und Rollout

Datenschutz im Alltag

- Keine Passwörter, Kontodaten oder personenbezogene Rohdaten in Prompts

- Freigegebene Modelle und Policies für sensible Anwendungsfälle

- Antworten vor externem Versand fachlich prüfen

Qualitätssteuerung

- Prompt-Standards pro Team definieren

- Output-Review in kritischen Prozessen verpflichtend machen

- Fehlermuster dokumentieren und in Prompts rückführen

Workflows & Integrationen

- Trigger-basierte Automationen für wiederkehrende Abläufe

- Native Integrationen plus optionale eigene Integrationen

- Rechte, Auditierbarkeit und Zuständigkeiten vorab klären

30-Tage-Einführungsplan

- Woche 1: Pilotteam + 3 Kern-Use-Cases

- Woche 2: Prompt Library und Review-Prozess

- Woche 3: Agent/Workflow-Pilot

- Woche 4: KPI-Messung und Rollout-Entscheid

Folie 08

Workshop Quiz: 20 Fragen

Assessment Mode

Frage 1 von 20

Frage

Lade Frage ...

Antwortblatt (20 Fragen)

Folie 09

Ressourcen und nächste Schritte

Wichtige Doku-Links

Empfohlener Follow-up Plan

- Ein Pilotprojekt pro Team aufsetzen

- Drei Standardprompts definieren und testen

- Ein Qualitäts-Review-Workflow einführen

- Einen wiederkehrenden Prozess als Agent/Workflow pilotieren

- Ergebnisse nach 30 Tagen anhand klarer KPIs auswerten